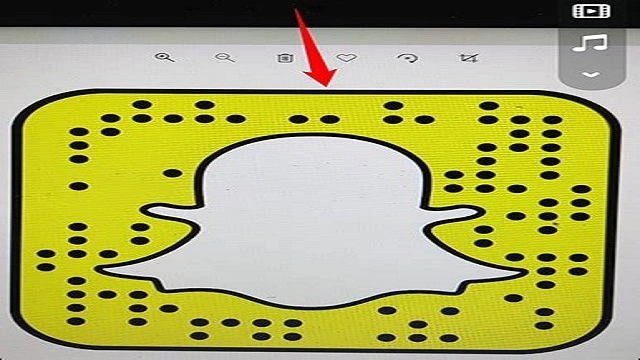

With the rise of Snapchat, Snapcodes have become a popular way to quickly add friends and followers. Snapcodes are unique QR codes that can be scanned to add someone on Snapchat or unlock special filters and lenses. However, what if you want to scan a Snapcode that you saved to your camera roll? In this article, we will show you how to scan Snapcode from camera roll.

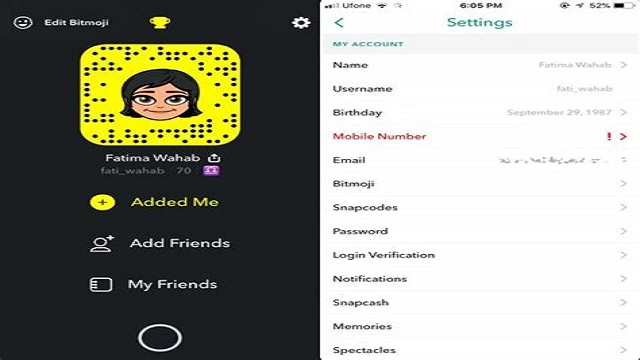

Step 1: Save the Snapcode to your camera roll

The first step is to save the Snapcode to your camera roll. If someone sends you a Snapcode on Snapchat, you can save it by taking a screenshot. To take a screenshot, press the home button and the power button at the same time on an iPhone or the power button and volume down button at the same time on an Android device. Once you have taken the screenshot, the Snapcode will be saved to your camera roll.

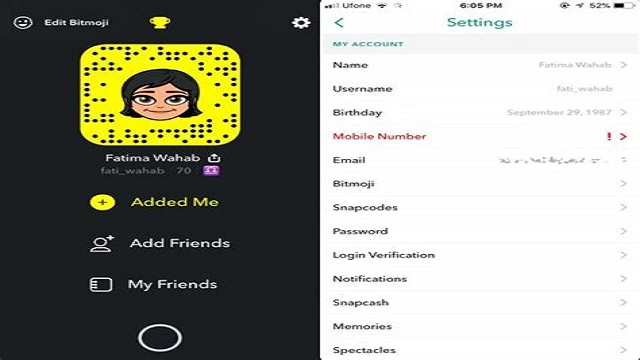

Step 2: Open the Snapcode in your camera roll

Next, open the Snapcode in your camera roll. To do this, simply go to your camera roll and find the screenshot of the Snapcode. Tap on the screenshot to open it.

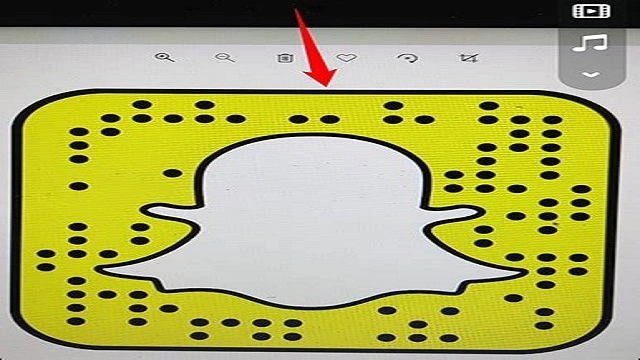

Step 3: Tap and hold on the Snapcode

Now, tap and hold on the Snapcode in your camera roll. This will bring up a menu with different options.

Step 4: Tap on “Scan Snapcode”

From the menu that appears, tap on “Scan Snapcode”. This will open Snapchat’s camera and automatically scan the Snapcode.

Step 5: Add the user on Snapchat

After scanning the Snapcode, you will be taken to the user’s profile on Snapchat. From here, you can add them as a friend or follow them.

Conclusion

Scanning a Snapcode from your camera roll is a quick and easy way to add someone on Snapchat or unlock special filters and lenses. By following the steps outlined in this article, you can easily scan any Snapcode that you have saved to your camera roll. Start scanning Snapcodes today and connect with your friends and followers on Snapchat!

Rekomendasi Lain:

- Cover for Cell Phone Camera Cell phones have become an integral part of our daily lives. We use them to communicate, take pictures, and access the internet. With the rise of social media and online…

- Deciding Best Medium Format Film Cameras Medium format film cameras are beloved by photographers for their ability to capture high-quality and detailed images. While many photographers have switched to digital cameras, there is still a strong…

- How to Select Multiple Photos on Mac As a Mac user, you might want to select multiple photos at once. This could be for various reasons such as organizing your photos, deleting unwanted photos, or sharing multiple…

- Best Camera for Car Photography Car photography is a unique genre that requires a specific set of tools to capture the perfect shot. One of the most important tools for car photography is the camera.…

- Can Blink Cameras Be Hacked? Blink cameras are one of the most popular home security cameras on the market. They are easy to install, affordable, and offer excellent features. However, many people are concerned about…

- Best Camera for Family Photography Capturing family moments is one of the best ways to preserve memories that can be cherished forever. However, choosing the right camera for family photography can be a daunting task.…

- Wilson Camera Digital Lab & Portrait Studio Wilson Camera Digital Lab & Portrait Studio is a world-class photography studio that offers a complete range of photography services. Whether you need professional portraits, family photos, or event coverage,…

- How to Save TikTok Drafts to Camera Roll If you are a TikTok user, you must have come across an interesting video that you would like to save to your camera roll. Sometimes, instead of sharing the video…

- Best Wireless Backup Camera for RV If you own an RV, you understand the importance of having a good backup camera. It makes maneuvering your vehicle much easier while increasing your safety on the road. However,…

- How to Add Highlights on Instagram from Camera Roll Instagram is one of the most popular social media platforms in the world, with over 1 billion active users. One of the features that make Instagram stand out is the…

- Canon Sure Shot Film Camera For those who are passionate about film photography, the Canon Sure Shot Film Camera is an excellent choice. This camera is easy to use, compact, and produces high-quality images, making…

- Best Video Camera Under $1000 When it comes to creating high-quality video content, having the right equipment can make all the difference. While there are certainly expensive cameras on the market that can produce stunning…

- WiFi Light Bulb Security Camera Reviews With the rise of smart home technology, WiFi light bulb security cameras have become increasingly popular. These innovative devices allow you to monitor your home from anywhere, using your smartphone…

- Top 5 Bird Feeders with Camera Bird watching is a popular hobby among nature lovers. Feeding birds in your garden or backyard is a great way to attract them and observe their behavior. With the advancement…

- Best Digital Camera for Vintage Look When it comes to photography, some people prefer the vintage look. The grainy, muted colors and soft focus of vintage photographs can evoke a sense of nostalgia and romanticism. Fortunately,…

- Safecam 360 Security Camera Review Home security is a top priority for everyone, and with the rise of technology, it has become easier to keep our homes safe. One of the most popular devices used…

- DIY Drone Kit with Camera: Building Your Own Aerial… Are you interested in aerial photography but don't want to spend a fortune on a ready-to-fly drone? Why not build your own drone kit with a camera? Not only is…

- Jeep Tire Covers with Camera Hole Jeep owners are known for their love for adventure and off-road exploration. To ensure that their vehicles are always protected on their journey, they invest in various accessories. One such…

- Best Underwater Camera for Snorkeling Snorkeling is a unique and exciting way to explore the underwater world. Whether you are a beginner or an experienced snorkeler, having an underwater camera can help you capture the…

- Fatshark Pan Tilt Roll Camera Mount and Servos: The Ultimate… If you are an avid drone enthusiast, you know how important it is to have a good camera mounting solution. That's where the Fatshark Pan/Tilt/Roll Camera Mount comes in. This…

- Blink Camera Flashing Red and Not Recording: How to Fix It If you own a Blink camera, you might have encountered a problem where the camera flashes red and doesn't record anything. This issue can be frustrating, especially if you rely…

- Sony Cyber Shot Camera 7.2 Megapixel Are you looking for a high-quality digital camera that can capture stunning photos and videos? Look no further than the Sony Cyber Shot Camera 7.2 Megapixel. This powerful camera is…

- Best Backpack Mount for 360 Camera If you're an adventure junkie or a travel enthusiast, then you must be aware of the importance of carrying a 360 camera with you. It's the perfect gadget to capture…

- Your Camera Roll Isnt Backed Up by Snapchat If you're an avid Snapchat user, you may be relying on the app to back up your camera roll. However, you may be surprised to learn that Snapchat doesn't actually…

- Best Camera for Boudoir Photography Boudoir photography is a genre of photography that captures intimate and sensual images of individuals. To create stunning boudoir photographs, a high-quality camera is essential. In this article, we will…

- How to Connect Your Canon Camera to Your Mac anon cameras have been widely popular for their high-quality images and videos. They offer a range of features that allow photographers to capture stunning shots. But what happens when you…

- How to Turn Off Flash on Canon Camera Flash photography can be a great way to capture stunning images, but there are times when flash is not desired. If you want to turn off the flash on your…

- Best Batteries for Trail Cameras When setting up a trail camera, one of the most important considerations is the type of battery you use. The battery is what powers the camera, and without it, you…

- How to Make a Reel with Photos Creating a reel with photos is a great way to showcase your memories and tell a story. It can be used for various purposes, including weddings, birthdays, and graduations. In…

- Best Batteries for Blink Camera If you have a Blink camera system, you know how important it is to have reliable and long-lasting batteries. After all, the last thing you want is for your cameras…